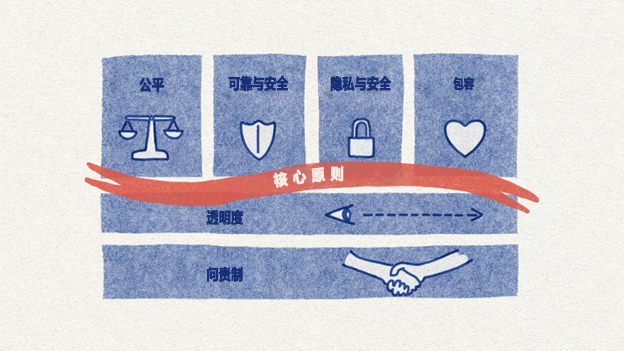

Microsoft 和 GitHub 的六项负责任 AI 原则

Microsoft 是负责任 AI 领域的全球领导者,确定了指导 AI 开发和使用的六项关键原则。 这些原则为:

- 公平:AI 系统应该公平对待所有人。

- 可靠性和安全性: AI 系统应安全可靠。

- 隐私和安全性: AI 系统应安全,并尊重隐私。

- 包容:AI 系统应该支持每个人并吸引人们参与。

- 透明:AI 系统应该是可理解的。

- 责任: 用户应负责 AI 系统。

现在,让我们更详细地探讨这些原则中的每一项,以了解它们如何指导负责任 AI 实践。

公平性:AI 系统应该公平对待所有人

AI 系统应该公平对待每个人,避免对处境类似的群体产生不同的影响。 在医疗、贷款申请或就业等方面,AI 应该为具有相似症状、财务状况或资格的个人提供一致的建议。

采用技术来检测偏差并降低不公平带来的影响,例如:

- 查看训练数据。

- 使用均衡的人口统计样本测试模型。

- 使用对抗性去偏差方法。

- 跨用户群体监视模型性能。

- 实施控制来替代不公平模型分数。

在多样化的和均衡的数据上训练 AI 模型有助于降低偏差,最终促进公平。

可靠性和安全性:AI 系统应可靠且安全地运行

若要建立信任,AI 系统必须可靠、安全、一致地运行。

这些系统需要按设计方式运行、安全地响应意外情况,并抵御有害操作。 其行为以及其所处理的各种情况反映了开发人员在设计和测试期间的预见。

AI 中的安全性是指尽量减少意外伤害,包括对个人和社会造成的身体、情感和经济伤害。 可靠性是指 AI 系统能够按照预期一致地运行,不会出现不必要的可变性或错误。 安全可靠的系统在正常情况下是稳健、准确且行为可预测的。

隐私和安全性:AI 系统应该安全,并且应该尊重隐私

随着人工智能 (AI) 变得越来越普遍,保护用户隐私和数据安全变得至关重要。 Microsoft 和 GitHub 意识到了这一点,两家公司都将隐私和安全性作为其负责任 AI 计划的关键部分。 该计划注重使用原则来指导数据实践。

Microsoft 和 GitHub 对负责任 AI 的做法旨在阻止滥用和维护用户信任。 要点包括:

- 在收集用户数据之前获得用户的许可。 清楚地说明 AI 会如何使用其数据,并且获得其同意。 不要秘密收集数据。 让用户选择是否愿意分享个人数据,并通过明确的提示和政策告知他们。

- 仅收集 AI 运行所需的数据。 一旦使用 AI,就应避免收集额外信息并删除敏感数据。 定期检查数据输入以确保只收集必要的数据。

- 将个人数据匿名化。 使用假名化和聚合等方法来保护标识。 假名化用随机标识符替换个人详细信息,而聚合则将数据分组成摘要,会删除特定的个人详细信息。

在传输和存储过程中对敏感数据进行加密。 通过以下方式使用强加密方法和安全密钥:

- 硬件安全模块 (HSM),用于将密钥存储在防篡改环境中。

- 像 Microsoft Azure 这样的安全保管库,用于带受控访问的密钥存储。

- 信封加密,使用两个密钥来提高安全性。

- 组织应对谁可以访问密钥和模型进行控制,应定期轮换密钥,并应安全地备份密钥。 组织还应限制员工对敏感模型和数据的访问,根据敏感度对其分类,并定期进行安全审核,以防止未经授权的访问。

包容性:AI 系统应该成为所有人的得力助手,并与人互动

包容性是指确保 AI 系统公平、可访问并成为所有人的得力助手。 Microsoft 的负责任 AI 标准认识到 AI 创建者(包括 GitHub)必须主动设计 AI,以涵盖所有人员、社区和地区 - 尤其是那些从历史角度来看代表性不足的社会领域。

Microsoft 的负责任 AI 包容性标准是指:

- AI 系统适用于各种不同的用户和群体。 它们不会对某些人不利。

- AI 系统是可以访问的。 任何人都可以轻松使用 AI 系统,无论身体能力或心智能力如何。

- AI 系统在全球范围内可用,即使在发展中国家/地区也是如此。 AI 系统不能排除某些地理区域。

- 来自不同背景和社区的人们为 AI 系统的发展提供了意见。

- AI 系统让所有用户都能平等地受益于其能力。 它们必须成为所有人的得力助手。

包容性 AI 的例子包括:

- 适用于不同肤色、年龄和性别的面部识别。

- 为视障人士提供屏幕阅读器支持的界面。

- 支持小众区域方言的语言翻译。

- 在设计系统时寻求不同观点的团队。

Microsoft 的负责任 AI 标准要求每个人都可以访问 AI 系统,无论其是否有残疾障碍、语言障碍或基础设施障碍。 负责任 AI 解决方案必须能够通过以下方式实现完全的全球包容性:

- 提供替代性的交互模式,例如语音控制、字幕和屏幕阅读器。

- 支持适应不同的语言和本地文化背景。

- 脱机工作,在连接和计算资源受限时正常工作。

透明度:AI 系统应该是可理解的

Microsoft 的负责任 AI 透明度原则强调 AI 系统必须是可理解的和可解释的。 AI 创建者应该:

- 通过清晰的验证框架清楚地说明其系统如何运行。

- 证明 AI 系统背后的设计选择的合理性。

- 坦陈 AI 系统的功能和局限性。

- 通过日志记录、报告和审核功能实现可审核性。

透明度对于建立信任、确保问责、促进公平、增强安全和支持包容性至关重要。 实现透明度涉及记录数据和模型、创建解释界面、使用 AI 调试工具、构建测试仪表板以及启用日志记录和审核。 AI 创建者保持透明度,可以促进信任并推广使用负责任 AI 标准。

问责:应有相关人员对 AI 系统负责

问责原则规定 AI 创建者应对其系统的运行方式负责。 他们需要持续监视系统性能并降低风险。 随着备受瞩目的算法伤害、偏见和滥用案例的曝光,AI 行业的问责正成为一个日益紧迫的问题。 批评者越来越认为,如果没有问责,AI 创建者就会对影响人们生活的不透明系统拥有过多权力。

Microsoft 通过其负责任 AI 标准强调 AI 开发和部署中的问责,该标准将问责视为一项基本原则。 根据 Microsoft 的说法,AI 系统必须对人负责,部署 AI 系统的公司必须对 AI 系统的运行负责。

现在让我们进行知识检查,复习一下刚学到的内容。