你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

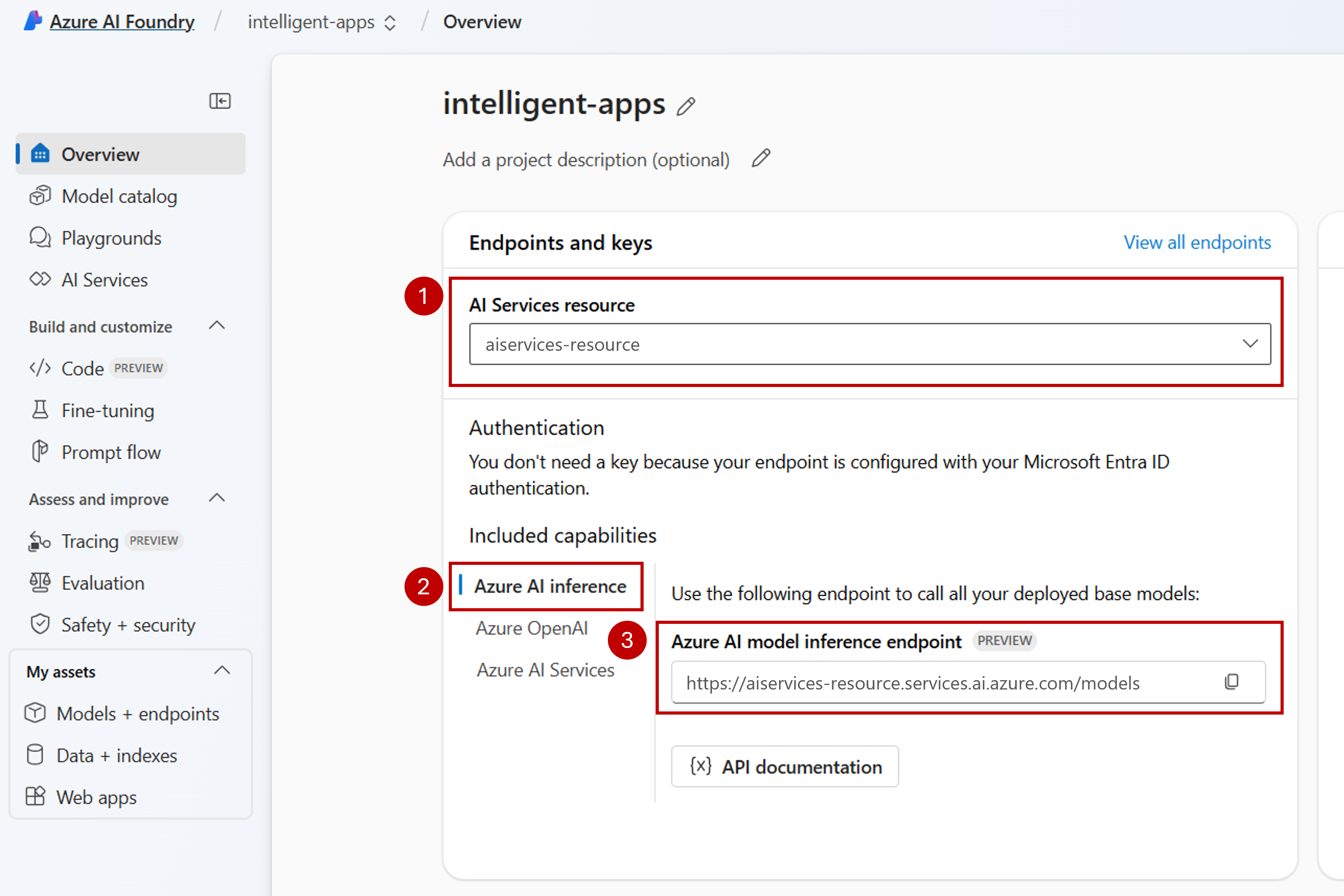

可以使用 Azure AI Foundry 项目中的 Azure AI Foundry 模型来创建丰富的应用程序并交互/管理可用的模型。 若要在项目中使用 Azure AI Foundry 模型服务,需要创建与 Azure AI Foundry 资源(以前已知的 Azure AI 服务)的连接。

以下文章介绍如何创建与 Azure AI Foundry 资源(以前已知的 Azure AI 服务)的连接,以使用 Azure AI Foundry 模型。

Prerequisites

若要完成本文,需要做好以下准备:

一份 Azure 订阅。 如果你正在使用 GitHub 模型,则可以升级体验并在此过程中创建 Azure 订阅。 如果是这种情况,请阅读 从 GitHub 模型升级到 Azure AI Foundry 模型 。

Azure AI Foundry 资源(以前称为 Azure AI 服务)。 有关详细信息,请参阅 创建和配置 Azure AI Foundry 模型的所有资源。

添加连接

可以使用以下步骤创建与 Azure AI 服务资源的连接:

在屏幕左下角,选择“管理中心”。

在 “连接资源 ”部分中,选择“ 新建连接”。

选择“Azure AI 服务”。

在浏览器中,在订阅中查找现有的 Azure AI 服务资源。

选择“添加连接”。

新连接将添加到你的中心。

返回到项目的登陆页面以继续,现在选择新建的连接。 如果页面未立即显示,请刷新该页面。

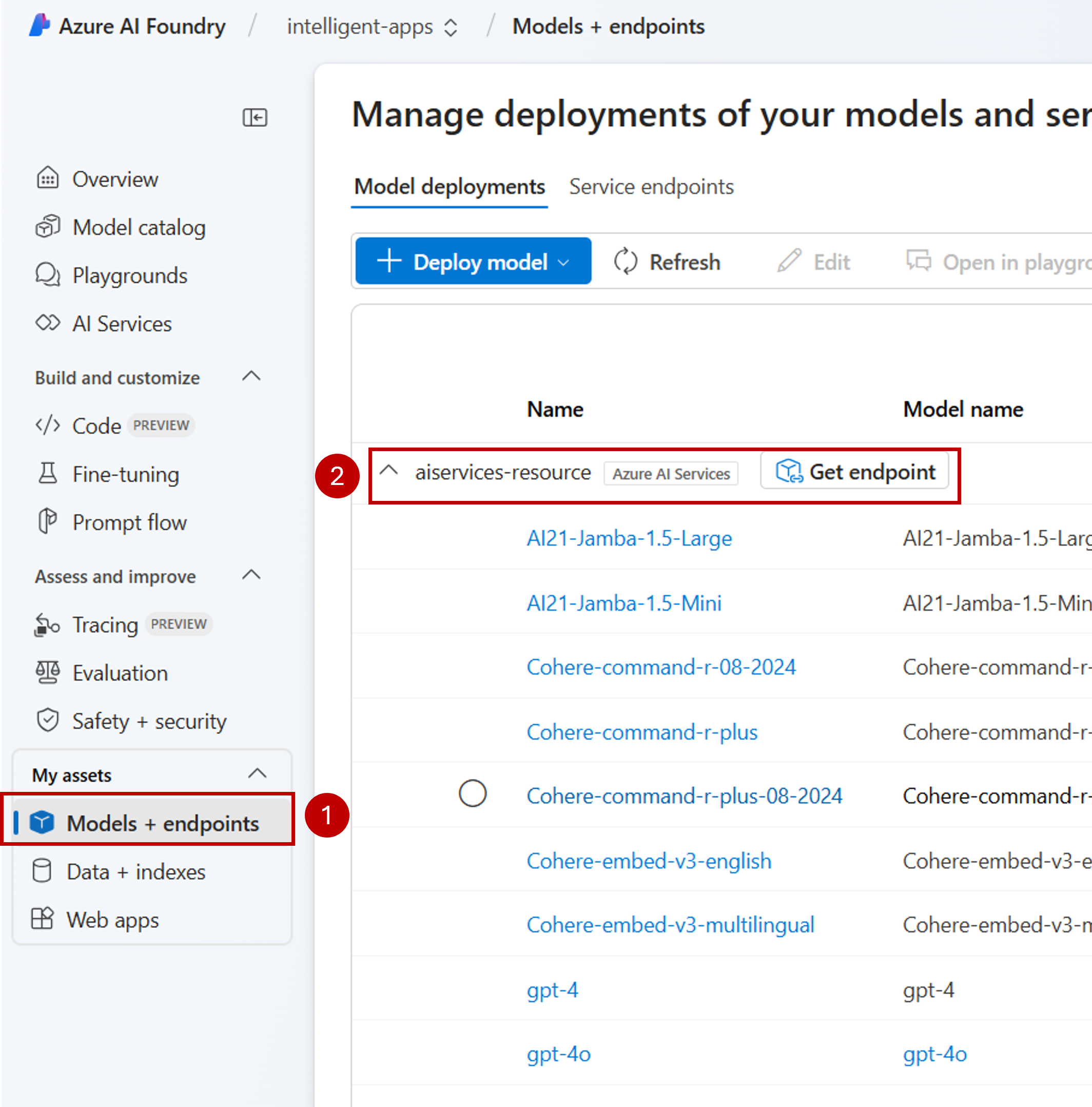

查看已连接资源中的模型部署

可以按照以下步骤查看已连接资源中可用的模型部署:

在左窗格中,选择 “模型 + 终结点”。

该页显示可用的模型部署,按连接名称分组。 找到刚刚创建的连接,该连接应属于 Azure AI 服务类型。

选择要检查的任何模型部署。

详细信息页显示有关特定部署的信息。 如果要测试模型,可以使用“在操场中打开”的选项。

将显示 Azure AI Foundry 操场,可在其中与给定模型进行交互。

可以使用 Azure AI Foundry 项目中的 Azure AI Foundry 模型来创建丰富的应用程序并交互/管理可用的模型。 若要在项目中使用 Azure AI Foundry 模型服务,需要创建与 Azure AI Foundry 资源(以前已知的 Azure AI 服务)的连接。

以下文章介绍如何创建与 Azure AI Foundry 资源(以前已知的 Azure AI 服务)的连接,以使用 Azure AI Foundry 模型。

Prerequisites

若要完成本文,需要做好以下准备:

一份 Azure 订阅。 如果你正在使用 GitHub 模型,则可以升级体验并在此过程中创建 Azure 订阅。 如果是这种情况,请阅读 从 GitHub 模型升级到 Azure AI Foundry 模型 。

Azure AI Foundry 资源(以前称为 Azure AI 服务)。 有关详细信息,请参阅 创建和配置 Azure AI Foundry 模型的所有资源。

安装适用于 Azure AI Foundry 的 Azure CLI 和

ml扩展:az extension add -n ml标识以下信息:

Azure 订阅 ID。

你的 Azure AI 服务资源名称。

在其中部署 Azure AI 服务资源的资源组。

添加连接

若要添加模型,首先需要标识要部署的模型。 可以按如下所示的方法查询可用模型:

登录到 Azure 订阅:

az login将 CLI 配置为指向该项目:

az account set --subscription <subscription> az configure --defaults workspace=<project-name> group=<resource-group> location=<location>创建连接定义:

connection.yml

name: <connection-name> type: aiservices endpoint: https://<ai-services-resourcename>.services.ai.azure.com api_key: <resource-api-key>创建连接:

az ml connection create -f connection.yml此时,连接可供使用。

可以使用 Azure AI Foundry 项目中的 Azure AI Foundry 模型来创建丰富的应用程序并交互/管理可用的模型。 若要在项目中使用 Azure AI Foundry 模型服务,需要创建与 Azure AI Foundry 资源(以前已知的 Azure AI 服务)的连接。

以下文章介绍如何创建与 Azure AI Foundry 资源(以前已知的 Azure AI 服务)的连接,以使用 Azure AI Foundry 模型。

Prerequisites

若要完成本文,需要做好以下准备:

一份 Azure 订阅。 如果你正在使用 GitHub 模型,则可以升级体验并在此过程中创建 Azure 订阅。 如果是这种情况,请阅读 从 GitHub 模型升级到 Azure AI Foundry 模型 。

Azure AI Foundry 资源(以前称为 Azure AI 服务)。 有关详细信息,请参阅 创建和配置 Azure AI Foundry 模型的所有资源。

具有 AI 中心的 Azure AI 项目。

安装 Azure CLI。

标识以下信息:

Azure 订阅 ID。

你的 Azure AI 服务资源名称。

你的 Azure AI 服务资源 ID。

部署项目的 Azure AI 中心的名称。

在其中部署 Azure AI 服务资源的资源组。

添加连接

使用模板

ai-services-connection-template.bicep描述连接:ai-services-connection-template.bicep

@description('Name of the hub where the connection will be created') param hubName string @description('Name of the connection') param name string @description('Category of the connection') param category string = 'AIServices' @allowed(['AAD', 'ApiKey', 'ManagedIdentity', 'None']) param authType string = 'AAD' @description('The endpoint URI of the connected service') param endpointUri string @description('The resource ID of the connected service') param resourceId string = '' @secure() param key string = '' resource connection 'Microsoft.MachineLearningServices/workspaces/connections@2024-04-01-preview' = { name: '${hubName}/${name}' properties: { category: category target: endpointUri authType: authType isSharedToAll: true credentials: authType == 'ApiKey' ? { key: key } : null metadata: { ApiType: 'Azure' ResourceId: resourceId } } }运行部署:

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" ENDPOINT_URI="https://<azure-ai-model-inference-name>.services.ai.azure.com" RESOURCE_ID="<resource-id>" HUB_NAME="<hub-name>" az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-connection-template.bicep \ --parameters accountName=$ACCOUNT_NAME hubName=$HUB_NAME endpointUri=$ENDPOINT_URI resourceId=$RESOURCE_ID