Anteckning

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

Den här artikeln visar hur du lägger till Confluent Cloud for Apache Kafka-källan i en händelseström.

Confluent Cloud for Apache Kafka är en strömningsplattform som erbjuder kraftfulla funktioner för dataströmning och bearbetning med Apache Kafka. Genom att integrera Confluent Cloud for Apache Kafka som en källa i din händelseström kan du sömlöst bearbeta dataströmmar i realtid innan du dirigerar dem till flera mål i Fabric.

Kommentar

Den här källan stöds inte i följande regioner i din arbetsytekapacitet: USA, västra 3, Schweiz, västra.

Förutsättningar

- Åtkomst till en arbetsyta i infrastrukturkapacitetslicensläget (eller) utvärderingslicensläget med deltagare eller högre behörigheter.

- Ett Confluent Cloud för Apache Kafka-kluster och en API-nyckel.

- Ditt Confluent Cloud for Apache Kafka-kluster måste vara offentligt tillgängligt och inte finnas bakom en brandvägg eller skyddas i ett virtuellt nätverk.

- Om du inte har en händelseström skapar du en händelseström.

Starta guiden Välj en datakälla

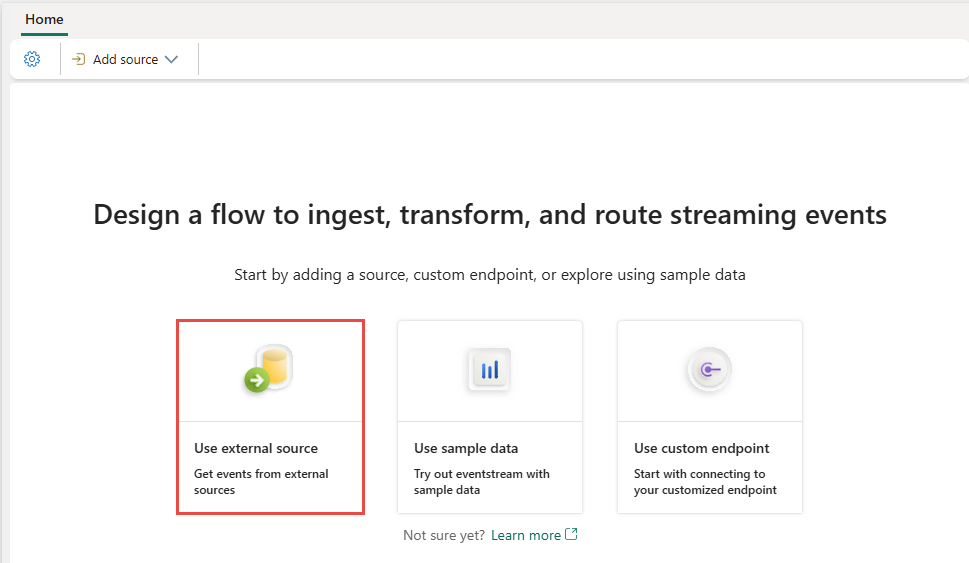

Om du inte har lagt till någon källa i händelseströmmen ännu väljer du Panelen Använd extern källa .

Om du lägger till källan i en redan publicerad händelseström växlar du till Redigeringsläge , väljer Lägg till källa i menyfliksområdet och väljer sedan Externa källor.

Konfigurera och ansluta till Confluent Cloud för Apache Kafka

På sidan Välj en datakälla väljer du Confluent Cloud för Apache Kafka.

Om du vill skapa en anslutning till Confluent Cloud for Apache Kafka-källan väljer du Ny anslutning.

I avsnittet Anslutningsinställningar anger du Confluent Bootstrap Server. Gå till startsidan för Confluent Cloud, välj Klusterinställningar och kopiera adressen till bootstrap-servern.

Om du har en befintlig anslutning till Confluent-klustret i avsnittet Anslutningsautentiseringsuppgifter väljer du den i listrutan för Anslutning. Annars följer du dessa steg:

- Som Anslutningsnamn anger du ett namn för anslutningen.

- För Typ av autentisering kontrollerar du att Confluent Cloud Key har valts.

- För API-nyckel och API-nyckelhemlighet:

Gå till ditt Confluent Cloud.

Välj API-nycklar på sidomenyn.

Välj knappen Lägg till nyckel för att skapa en ny API-nyckel.

Kopiera API-nyckeln och hemligheten.

Klistra in dessa värden i fälten API Key och API Key Secret .

Välj Anslut

Bläddra för att se avsnittet Konfigurera Confluent Cloud för Apache Kafka-datakälla på sidan. Ange informationen för att slutföra konfigurationen av Confluent-datakällan.

För Ämnesnamn anger du ett ämnesnamn från ditt Confluent Cloud. Du kan skapa eller hantera ditt ämne i Confluent Cloud Console.

För konsumentgrupp anger du en konsumentgrupp för ditt Confluent Cloud. Det ger dig den dedikerade konsumentgruppen för att hämta händelserna från Confluent Cloud-klustret.

För Inställningen Återställ automatisk förskjutning väljer du något av följande värden:

- Tidigast – de tidigaste data som är tillgängliga från ditt Confluent-kluster.

- Senaste – de senaste tillgängliga data.

- Ingen – Ställ inte in förskjutningen automatiskt.

Kommentar

Alternativet Ingen är inte tillgängligt under det här skapandesteget. Om det finns en bekräftad förskjutning och du vill använda Ingen kan du först slutföra konfigurationen och sedan uppdatera inställningen i redigeringsläget Eventstream.

Beroende på om dina data kodas med hjälp av Confluent Schema Registry:

- Om det inte är kodat, välj Nästa. På skärmen Granska och skapa granskar du sammanfattningen och väljer sedan Lägg till för att slutföra installationen.

- Om kodas fortsätter du till nästa steg: Anslut till Confluent-schemaregistret för att avkoda data (förhandsversion)

Ansluta till Confluent-schemaregistret för att avkoda data (förhandsversion)

Eventstream's anslutningsprogram för Apache Kafka-strömning i Confluent Cloud kan avkoda data som produceras med Confluent-serialiseraren och schemaregistret från Confluent Cloud. Data som kodas med den här serialiseraren av Confluent-schemaregistret kräver schemahämtning från Confluent Schema Registry för avkodning. Utan åtkomst till schemat kan Eventstream inte förhandsgranska, bearbeta eller dirigera inkommande data.

Du kan expandera Avancerade inställningar för att konfigurera Confluent Schema Registry-anslutning:

Definiera och serialisera data: Med Välj Ja kan du serialisera data till ett standardiserat format. Välj Nej behåller data i sitt ursprungliga format och skickar dem utan ändringar.

Om dina data kodas med hjälp av ett schemaregister väljer du Ja när du väljer om data ska kodas med ett schemaregister. Välj sedan Ny anslutning för att konfigurera åtkomst till ditt Confluent Schema Registry:

- Schemaregister-URL: Den offentliga slutpunkten för ditt schemaregister.

- API-nyckel och API-nyckelhemlighet: Gå till Confluent Cloud Environments schemaregister för att kopiera API-nyckeln och API-hemligheten. Kontrollera att kontot som används för att skapa den här API-nyckeln har DeveloperRead - eller högre behörighet i schemat.

- Sekretessnivå: Välj mellan Ingen, Privat, Organisation eller Offentlig.

JSON-utdata decimalformat: Anger JSON-serialiseringsformatet för logiska decimaltypvärden i data från källan.

- NUMERISK: Serialisera som tal.

- BASE64: Serialisera som base64-kodade data.

Välj Nästa. På skärmen Granska och skapa granskar du sammanfattningen och väljer sedan Lägg till för att slutföra installationen.

Du ser att källan Confluent Cloud för Apache Kafka har lagts till i din eventstream på arbetsytan i redigeringsläge. Om du vill implementera den nyligen tillagda Confluent Cloud for Apache Kafka-källan väljer du Publicera i menyfliksområdet.

När du har slutfört de här stegen är Confluent Cloud for Apache Kafka-källan tillgänglig för visualisering i livevyn.

Kommentar

Om du vill förhandsgranska händelser från det här Confluent Cloud for Apache Kafka-källan kontrollerar du att API-nyckeln som används för att skapa molnanslutningen har läsbehörighet för konsumentgrupper med prefixet "preview-". Om API-nyckeln har skapats med ett användarkonto krävs inga ytterligare steg eftersom den här typen av nyckel redan har fullständig åtkomst till confluentmolnet för Apache Kafka-resurser, inklusive läsbehörighet för konsumentgrupper som är prefix med "preview-". Men om nyckeln skapades med ett tjänstkonto måste du manuellt ge läsbehörighet till konsumentgrupper som har prefixet "preview-" för att kunna förhandsgranska händelser.

För Confluent Cloud för Apache Kafka-källor stöds förhandsversion för meddelanden i Confluent AVRO-format när data kodas med hjälp av Confluent Schema Registry. Om data inte kodas med Confluent Schema Registry kan endast JSON-formaterade meddelanden förhandsgranskas.

Relaterat innehåll

Andra anslutningsappar: