Anteckning

Åtkomst till den här sidan kräver auktorisering. Du kan prova att logga in eller ändra kataloger.

Åtkomst till den här sidan kräver auktorisering. Du kan prova att ändra kataloger.

Om du redan har ett AI-projekt i Azure AI Foundry distribuerar modellkatalogen modeller från partnermodellleverantörer som fristående slutpunkter i projektet som standard. Varje modelldistribution har en egen uppsättning URI och autentiseringsuppgifter för åtkomst till den. Å andra sidan distribueras Azure OpenAI-modeller till Azure AI Foundry-resursen eller till Azure OpenAI i Azure AI Foundry Models-resursen.

Du kan ändra det här beteendet och distribuera båda typerna av modeller till Azure AI Foundry (tidigare kända Azure AI Services). När de har konfigurerats sker distributioner av modeller som serverlösa API-distributioner till den anslutna Azure AI Foundry-resursen i stället till själva projektet, vilket ger dig en enda uppsättning slutpunkter och autentiseringsuppgifter för att få åtkomst till alla modeller som distribueras i Azure AI Foundry. Du kan hantera modeller från Azure OpenAI och partnermodellprovidrar på samma sätt.

Dessutom ger distribution av modeller till Azure AI Foundry Models de extra fördelarna med:

- Routningsfunktion

- Anpassade innehållsfilter

- Distributionstyp för global kapacitet

- Nyckellös autentisering med Microsoft Entra-ID

I den här artikeln får du lära dig hur du konfigurerar projektet så att det använder Foundry Models-distributioner.

Förutsättningar

För att slutföra denna handledning behöver du:

Ett Azure-abonnemang. Om du använder GitHub-modeller kan du uppgradera din upplevelse och skapa en Azure-prenumeration i processen. Mer information finns i Uppgradera från GitHub-modeller till Foundry-modeller.

Azure AI Foundry-resurs Mer information finns i Skapa din första AI Foundry-resurs.

Ett Azure AI Foundry-projekt och en hubb. Mer information finns i Skapa och hantera en Azure AI Foundry-hubb.

Tips/Råd

När ai-hubben etableras skapas en Azure AI Foundry-resurs med den och de två resurserna är anslutna. Om du vill se vilken resurs som är ansluten till projektet går du till Azure AI Foundry Portal>Management Center>Anslutna resurser och hittar anslutningar av typen AI-tjänster.

Konfigurera projektet så att det använder Foundry Models

Så här konfigurerar du projektet för att använda funktionen Foundry Models i Azure AI Foundry:

På projektets landningssida väljer du Hanteringscenter längst ned på sidomenyn. Identifiera azure AI Foundry-resursen som är ansluten till projektet.

Om ingen resurs visas har din AI-hubb inte någon Azure AI Foundry-resurs ansluten till den. Skapa en ny anslutning.

Välj +Ny anslutning och välj sedan Azure AI foundry från plattorna.

Leta efter en befintlig resurs i prenumerationen i fönstret och välj sedan Lägg till anslutning.

Den nya anslutningen läggs till i hubben.

Gå tillbaka till projektets landningssida.

Under Inkluderade funktioner ser du till att du väljer Azure AI-slutsatsdragning. Slutpunkts-URI:n för Foundry Models visas tillsammans med autentiseringsuppgifterna för att få åtkomst till den.

Tips/Råd

Varje Azure AI Foundry-resurs har en enda Foundry Models-slutpunkt som kan användas för att komma åt alla modelldistributioner på den. Samma slutpunkt hanterar flera modeller beroende på vilka som är konfigurerade. Information om hur slutpunkten fungerar finns i Slutpunkten för Azure OpenAI-slutsatsdragning.

Anteckna slutpunkts-URL:en och autentiseringsuppgifterna.

Skapa modelldistributionen i Foundry Models

Följ dessa steg för varje modell som du vill distribuera under Foundry Models:

Gå till modellkatalogen i Azure AI Foundry-portalen.

Rulla till den modell som du är intresserad av och välj den.

Du kan granska informationen om modellen på modellkortet.

Välj Använd den här modellen.

För modellleverantörer som kräver fler kontraktsvillkor uppmanas du att acceptera dessa villkor genom att välja Godkänn och fortsätta.

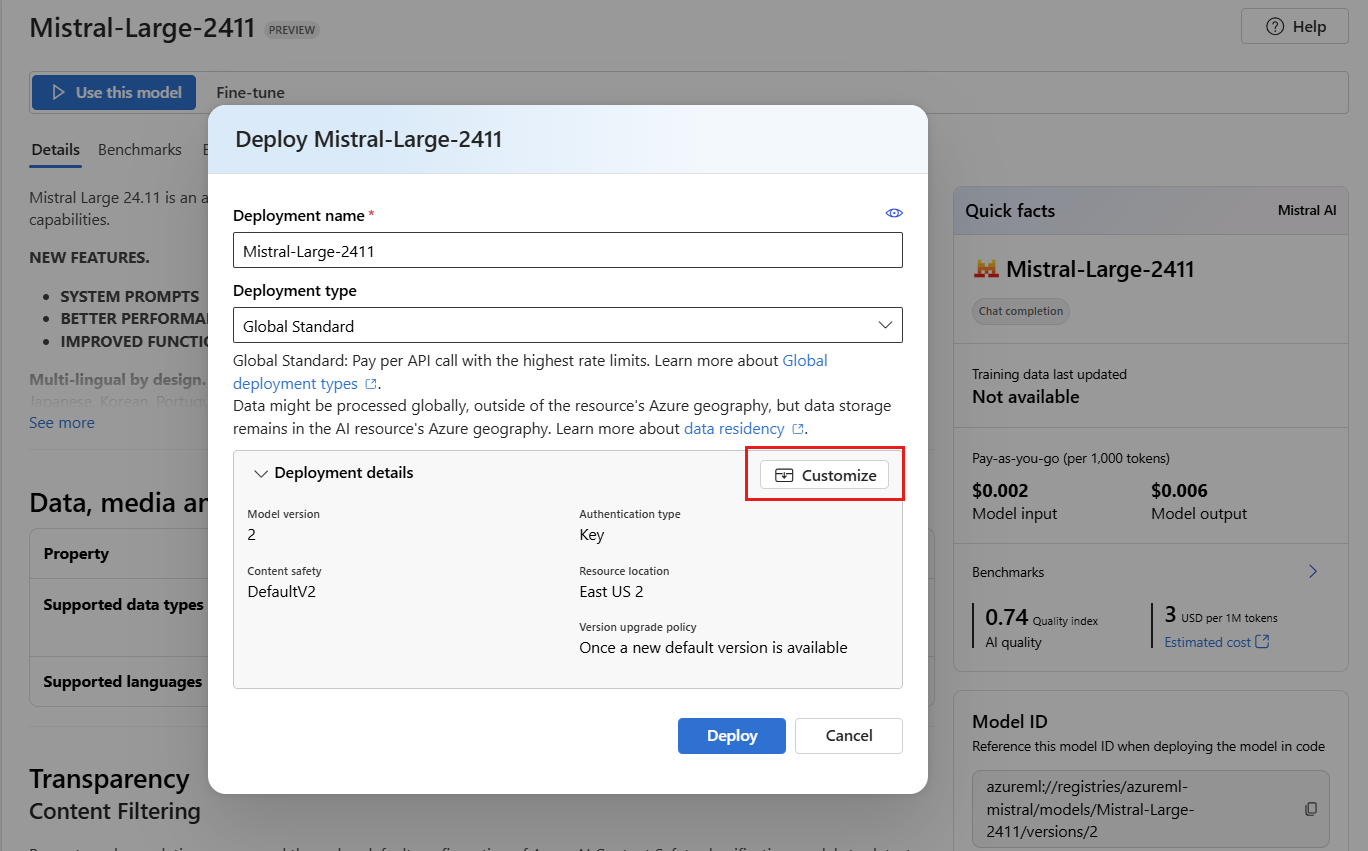

Du kan konfigurera distributionsinställningarna just nu. Som standard tar distributionen emot namnet på den modell som du distribuerar. Distributionsnamnet används i parametern

modelför begäran om att dirigera till just den här modelldistributionen. Det gör att du kan konfigurera specifika namn för dina modeller när du kopplar specifika konfigurationer. Till exempelo1-preview-safeför en modell med ett strikt innehållsfilter.Vi väljer automatiskt en Azure AI Foundry-anslutning beroende på ditt projekt eftersom du har aktiverat funktionen Distribuera modeller till Azure AI-modellinferenstjänsten. Välj Anpassa för att ändra anslutningen baserat på dina behov. Om du distribuerar under den serverlösa API-distributionstypen måste modellerna vara tillgängliga i regionen för Foundry-resursen.

Välj Distribuera.

När distributionen är klar visas slutpunkts-URL:en och autentiseringsuppgifterna för att få åtkomst till modellen. Observera att den angivna URL:en och autentiseringsuppgifterna nu är desamma som på landningssidan för projektet för slutpunkten Foundry Models.

Du kan visa alla tillgängliga modeller under resursen genom att gå till avsnittet Modeller + slutpunkter och hitta gruppen för anslutningen till resursen:

Uppgradera koden med den nya slutpunkten

När din Azure AI Foundry-resurs har konfigurerats kan du börja använda den från din kod. Du behöver slutpunkts-URL:en och nyckeln för den, som finns i avsnittet Översikt :

Du kan använda någon av de SDK:er som stöds för att få ut förutsägelser från slutpunkten. Följande SDK:er stöds officiellt:

- OpenAI SDK

- Azure OpenAI SDK

- Azure AI-slutsatsdragningspaket

- Azure AI Projects-paket

Mer information och exempel finns i Programmeringsspråk som stöds för Azure AI Inference SDK. I följande exempel visas hur du använder Azure AI Inference-paketet med den nyligen distribuerade modellen:

Installera paketet azure-ai-inference med hjälp av pakethanteraren, till exempel pip:

pip install azure-ai-inference

Sedan kan du använda paketet för att konsumera modellen. I följande exempel visas hur du skapar en klient för att hantera chattavslut:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

client = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZURE_INFERENCE_CREDENTIAL"]),

)

Utforska våra exempel och läs API-referensdokumentationen för att komma igång.

Generera din första chattavslutning:

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Använd parametern model="<deployment-name> för att dirigera din begäran till den här distributionen.

Distributioner fungerar som ett alias för en viss modell under vissa konfigurationer. Information om hur Azure AI Foundry Models dirigerar distributioner finns i Routning.

Flytta från serverlösa API-distributioner till Foundry-modeller

Även om du har konfigurerat projektet för att använda Foundry-modeller, fortsätter befintliga modelldistributioner att finnas i projektet som serverlösa API-distributioner. Dessa utrullningar flyttas inte åt dig. Därför kan du progressivt uppgradera befintlig kod som refererar till tidigare modelldistributioner. För att börja flytta modelldistributionerna rekommenderar vi följande arbetsflöde:

Återskapa modelldriftsättningen i Foundry Models. Den här modellimplementeringen är tillgänglig under slutpunkten Foundry Models.

Uppgradera koden så att den nya slutpunkten används.

Rensa projektet genom att ta bort den serverlösa API-distributionen.

Uppgradera koden med den nya slutpunkten

När modellerna har distribuerats under Azure AI Foundry kan du uppgradera koden för att använda slutpunkten Foundry Models. Den största skillnaden mellan hur serverlösa API-distributioner och Foundry Models fungerar finns i slutpunkts-URL:en och modellparametern. Även om serverlösa API-distributioner har en uppsättning URI och nycklar per modelldistribution, har Foundry Models bara en för alla.

I följande tabell sammanfattas de ändringar som du måste införa:

| Fastighet | serverlösa API-distributioner | Foundry-modeller |

|---|---|---|

| Slutpunkt | https://<endpoint-name>.<region>.inference.ai.azure.com |

https://<ai-resource>.services.ai.azure.com/models |

| Behörigheter | En per modell/slutpunkt. | En resurs per Foundry. Du kan också använda Microsoft Entra-ID. |

| Modellparameter | Ingen. | Obligatoriskt. Använd namnet på modellutplaceringen. |

Rensa befintliga serverlösa API-distributioner från projektet

När du har omstrukturerat koden kanske du vill ta bort befintliga serverlösa API-distributioner i projektet (om det finns några).

Följ dessa steg för varje modell som distribueras som serverlösa API-distributioner:

Gå till Azure AI Foundry-portalen.

Välj Modeller + slutpunkter och välj sedan fliken Tjänstslutpunkter .

Identifiera slutpunkterna för typ av serverlös API-distribution och välj den som du vill ta bort.

Välj alternativet Ta bort.

Varning

Det går inte att återställa den här åtgärden. Kontrollera att slutpunkten för närvarande inte används av någon annan användare eller kod.

Bekräfta åtgärden genom att välja Ta bort.

Om du har skapat en serverlös API-distributionsanslutning till den här slutpunkten från andra projekt tas sådana anslutningar inte bort och fortsätter att peka på den obefintliga slutpunkten. Ta bort någon av dessa anslutningar för att undvika fel.

Begränsningar

Tänk på följande begränsningar när du konfigurerar projektet för att använda Foundry Models:

- Endast modeller som stöder serverlösa API-distributioner är tillgängliga för distribution till Foundry Models. Modeller som kräver beräkningskvot från din prenumeration (hanterad beräkning), inklusive anpassade modeller, kan bara distribueras inom ett visst projekt som hanterade online-slutpunkter och fortsätter att vara tillgängliga med sina egna slutpunkts-URI:er och autentiseringsuppgifter.

- Modeller som är tillgängliga som både serverlösa API-distributioner och hanterade beräkningserbjudanden distribueras som standard till Foundry Models i Azure AI Foundry-resurser. Azure AI Foundry-portalen erbjuder inte något sätt att distribuera dem till hanterade onlineslutpunkter. Du måste inaktivera funktionen som nämns i Konfigurera projektet för att använda Foundry Models eller använda Azure CLI/Azure ML SDK/ARM-mallarna för att utföra distributionen.