Notitie

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen u aan te melden of de directory te wijzigen.

Voor toegang tot deze pagina is autorisatie vereist. U kunt proberen de mappen te wijzigen.

Ontdek de kracht van Generatieve AI met JavaScript. Meer informatie over het naadloos integreren van AI in uw web-, mobiele of desktoptoepassingen.

JavaScript met AI?

Hoewel het waar is dat Python ideaal is voor het maken en trainen van AI-modellen, is het bouwen van apps met deze modellen anders. De meeste AI-modellen werken via web-API's, zodat elke taal die HTTP-aanroepen kan maken AI kan gebruiken. JavaScript is platformoverschrijdend en verbindt eenvoudig browsers en servers, waardoor het een sterke keuze is voor AI-apps.

Leuke en interactieve cursus

Neem deel aan een meeslepende leerervaring, waaronder video's, codeprojecten en een volledige implementatie om zowel gebruik te maken als meer te leren over generatieve AI.

Deze cursus is een geweldige manier voor studenten en nieuwe ontwikkelaars om op een leuke, interactieve manier over AI te leren. Voor ontwikkelaars die aan hun carrière werken, verdiep je in het verbeteren van je AI-vaardigheden.

In deze cursus:

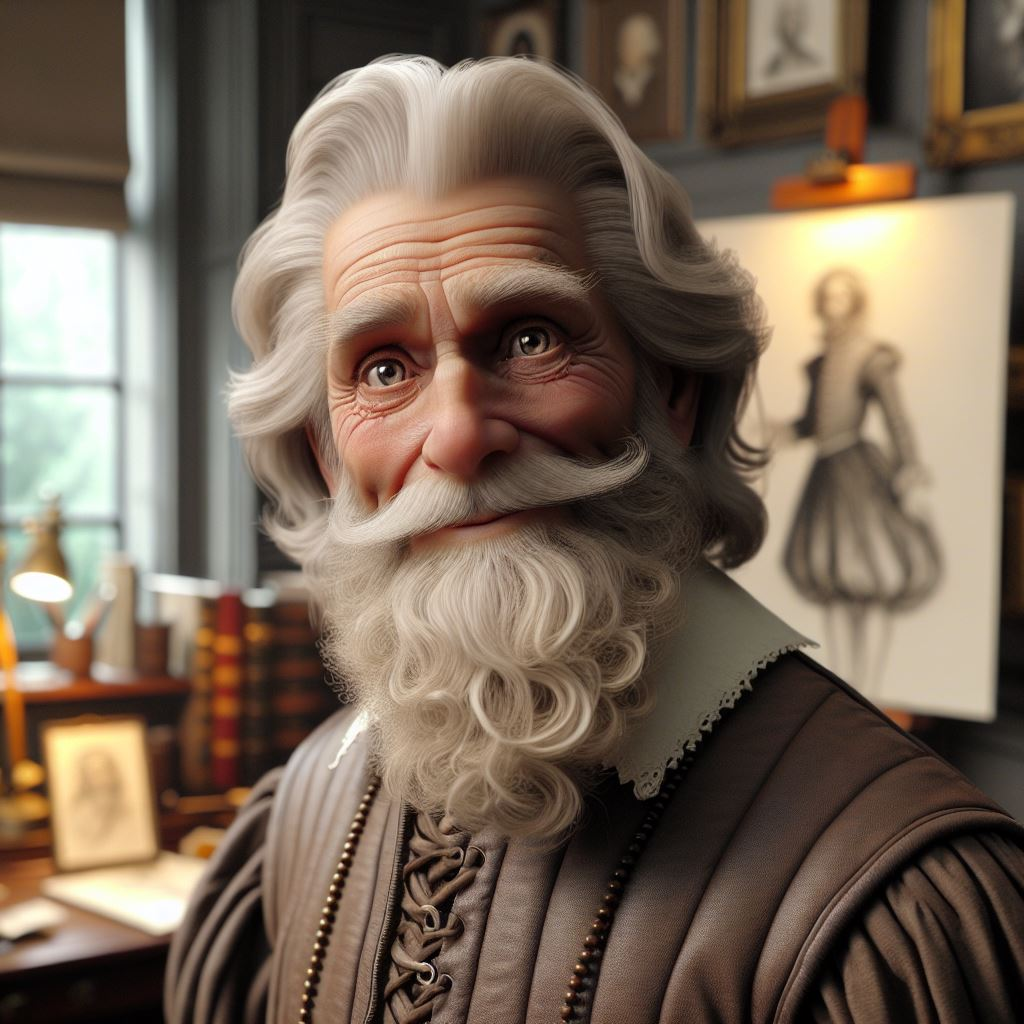

- Leer AI tijdens het tot leven brengen van historische figuren met generatieve kunstmatige intelligentie.

- Toegankelijkheid toepassen met de ingebouwde browser-API's

- Tekst- en afbeeldingsgeneratie gebruiken om AI te integreren in de app-ervaring

- Architectuurpatronen leren voor AI-toepassingen

De bijbehorende toepassing gebruiken om met historische tekens te praten

Wat moet u weten over LLM's?

Grote taalmodellen (LLM's) zijn deep neurale netwerken die zijn getraind op veel gegevens om tekst te begrijpen en te maken. Training begint met grote, diverse gegevenssets om een basismodel te bouwen en gebruikt vervolgens speciale gegevens om betere resultaten te verfijnen. LLM's werken als slimme hulpprogramma's voor automatisch aanvullen in code-editors of chat-apps. Modellen hebben limieten, zoals contextvensters (meestal een paar duizend tokens, hoewel nieuwere modellen meer ondersteunen) en kunnen vooroordelen van hun trainingsgegevens weergeven. Daarom is het belangrijk dat verantwoordelijke AI zich richt op redelijkheid, betrouwbaarheid, privacy en verantwoordelijkheid, zoals Microsoft aanbeveelt.

Meer informatie in de LLM-sessie van de cursus:

Essentiële prompt engineeringtechnieken

Prompt engineering betekent het ontwerpen van prompts om betere AI-resultaten te krijgen. U kunt zero-shot learning (geen voorbeelden) of weinig-shot learning (met voorbeelden) gebruiken om het model te begeleiden. Het toevoegen van aanwijzingen zoals stapsgewijze instructies, duidelijke context en uitvoerindelingen helpt het model betere antwoorden te geven. U kunt ook toon aanpassen en antwoorden aanpassen. Deze basisprincipes stellen u in voor geavanceerde technieken zoals RAG.

Meer informatie in de prompt engineering sessie van de cursus:

Nauwkeurigheid en betrouwbaarheid van AI verbeteren met RAG

Gebruik Rag (Retrieval Augmented Generation) om AI nauwkeuriger en betrouwbaarder te maken. RAG combineert een retriever die up-to-datumdocumenten vindt met een generator die deze documenten gebruikt om vragen te beantwoorden. Deze aanpak geeft duidelijke, feitelijke antwoorden op basis van vertrouwde bronnen, waardoor resultaten eenvoudig te controleren en rendabel zijn. Contoso-ondersteuning voor onroerend goed maakt bijvoorbeeld gebruik van RAG om gedetailleerde antwoorden te geven die worden ondersteund door bedrijfsdocumenten.

Meer informatie in de RAG-sessie van de cursus:

Uw AI-ontwikkeling versnellen met LangChain.js

Uw AI-projecten versnellen met LangChain.js. Met deze JavaScript-bibliotheek kunt u eenvoudig werken met grote taalmodellen. Gebruik LangChain.js om promptsjablonen te maken, modellen en vectordatabases te verbinden en complexe werkstromen te maken. Snel prototype-apps, zoals een API die vragen van YouTube-transcripties ophaalt en beantwoordt. Wanneer u klaar bent voor productie, wisselt u lokale modellen en vectorarchieven voor Azure-services zonder uw code te wijzigen.

Meer informatie in de LangChain.js sessie van de cursus:

AI-modellen uitvoeren op uw lokale computer met Ollama

Download en gebruik lokale AI-modellen met Ollama, een opensource-hulpprogramma op basis van llama.cpp, om efficiënt kleine taalmodellen zoals Phi-3 uit te voeren. Lokale modellen elimineren de afhankelijkheid van de cloudinfrastructuur, maken snelle ontwikkeling mogelijk met offlinemogelijkheden en bieden rendabele tests via een snelle interne ontwikkelingslus. Phi-3, bekend om zijn hoge prestaties en verantwoorde AI-veiligheid, kan zelfs worden uitgevoerd op gematigde specificaties en is toegankelijk via een OpenAI-compatibele API, waardoor het eenvoudig kan worden geïntegreerd met uw ontwikkelwerkstroom.

Meer informatie in de Ollama-sessie van de cursus:

Gratis aan de slag met AI met Phi-3

Probeer AI-modellen met het Ollama-hulpprogramma en Phi-3-model in uw browser met behulp van een onlinespeeltuin. Maak een GitHub Codespace om VS Code in uw browser te gebruiken, voer opdrachten uit zoals Ollama run phi3 om met het model te chatten en gebruik een Jupyter-notebook om prompt engineering, weinig-shot learning en RAG te testen. U kunt AI-projecten online bouwen en verkennen. U hebt geen snelle GPU of lokale installatie nodig.

Meer informatie in de Phi-3-sessie van de cursus:

Inleiding tot Azure AI Foundry

Gebruik Azure AI Foundry om te beginnen met het bouwen van generatieve AI-apps met JavaScript. Organiseer resources met hubs en projecten, blader door duizenden modellen en implementeer een model om te testen in een speeltuin. Of u nu beheerde compute- of serverloze API's kiest, volg dezelfde stappen om uw model in uw werkstroom te selecteren, te implementeren en te gebruiken.

Meer informatie in de Azure AI Foundry-sessie van de cursus:

Generatieve AI-apps bouwen met Azure Cosmos DB

Meer informatie in de Azure Cosmos DB-sessie van de cursus:

Azure-hulpprogramma's & services voor het hosten en opslaan van AI-apps

Ontdek belangrijke Azure-hulpprogramma's en -services voor het hosten en opslaan van uw AI-apps. Bouw verschillende typen AI-apps, zoals chat-apps, RAG en autonome agents. Gebruik de Azure Developer CLI (AZD) om eenvoudig te implementeren. Vergelijk serverloze en containergebaseerde opties en leer hoe u uw API's veilig, schaalbaar en bewaakt kunt houden voor gebruik in de praktijk.

Meer informatie in de sessie met Azure-hulpprogramma's en -services van de cursus:

Streamen van Generatieve AI-uitvoer met het AI-Chatprotocol

Streamgeneratieve AI-uitvoer met het AI Chat-protocol. Dit hulpprogramma maakt realtime communicatie eenvoudig tussen uw AI-service en client-apps. Probeer twee streamingmethoden: voer deductie uit in de browser of gebruik een AI-deductieserver. Let op blootstelling van API-sleutels, gegevensveiligheid en het kiezen van het juiste protocol. Met de eenvoudige client van AI Chat Protocol kunt u beveiligde en efficiënte streaming toevoegen aan uw app met behulp van getCompletion- en getStreamedCompletion-methoden, zoals wordt weergegeven in onze serverloze RAG met LangChain.js voorbeeld.

Meer informatie in de streamingsessie van de cursus: